Привет, я data scientist в «тинькофф»

Содержание:

- Что мне нравится в моей работе

- №5. Профессия Data Scientist

- Образование в области Data Science: ничего невозможного нет

- Data Scientist: кто это и что он делает

- Пример: профилактика диабета

- Требования к специалисту

- Как начать?

- Что делает дата-инженер?

- Как дела обстоят у нас

- Что изучает Data Science

- 2017: Высшая школа экономики будет обучать Data Culture на всех программах бакалавриата

Что мне нравится в моей работе

Я работаю в «Тинькофф» уже три с половиной года. В нашей компании много задач для сайентистов и почти нет ограничений по развитию. Наука о данных — достаточно универсальная область

По сути тебе не важно какими данными ты занимаешься: о торговле продуктами или о поведении пользователей в интернете. Для всех задач есть одинаковая база: математика и программирование

Зная базовые вещи уже можно углубляться в конкретные области, например, компьютерное зрение или обработку естественного языка.

Большинство задач в индустрии довольно стандартные, они ориентированы прежде всего на бизнес-результат. Поэтому в какой-то момент каждому специалисту хочется начать делать что-то свое параллельно основной работе. Я, например, хотел бы привнести что-то новое в open-source (программы и технологии для разработчиков), но пока своих значимых кейсов нет.

Мне нравится создавать технологии, которые автоматизируют ручную работу. Например, известная в машинном обучении библиотека scikit-learn поделила профессию на «до» и «после»: у разработчиков появились инструменты для быстрой работы с алгоритмами ML.

Еще мне хотелось бы углубиться в другие области машинного обучения. Я занимаюсь временными рядами, обычно в этой специализации лучше работают классические модели. И хочу поглубже копнуть в Deep Learning — глубинное обучение, где нейросети способны решать очень сложные задачи. Именно в этой области сейчас происходят наиболее интересные в машинном обучении вещи.

Курс

Полный курс по Data Science

Освойте востребованную профессию с нуля за 12 месяцев и станьте уверенным junior-специалистом.

- Индивидуальная поддержка менторов

- 10 проектов в портфолио

- Помощь в трудоустройстве

Получить скидку Промокод “BLOG10” +5% скидки

№5. Профессия Data Scientist

Платформа обучения: SkillFactory – онлайн-школа программирования и управления продуктами.

Кому подойдет: Новичкам, ранее на сталкивавшимся с профессией Data Scientist, но мечтающим сменить работу и найти место в IT-сфере. Подойдет даже тем, кто лишь поверхностно знаком с математикой, алгеброй и статистикой.

Длительность курса: 24 месяца. Еженедельная нагрузка – не менее 10 часов. Включает теорию и практические испытания, основанные на реальных кейсах.

Сертификат или диплом: Да, персональный сертификат о прохождении специализации. По запросу студентов выдается на английском языке.

Трудоустройство: Консультации с менторами и экспертами, помощь с оформлением портфолио, поиском вакансий, прохождением собеседований. После выпуска откроется доступ к закрытому сообществу с инсайтами, заказами от работодателей.

Стоимость курса: Зависит от выбранного тарифа. Базовый вариант обойдется в 6900 рублей в месяц при рассрочке на 2 года. Включает разбор заданий, интерактивные вебинары, доступ ко всем материалам навсегда и регистрация в «Центре карьеры».

«Оптимальный» тариф стоит 9 720 рублей в месяц (рассрочка на 2 года) и дополнительно разрешает общаться с ментором в течение 12 часов и провести разовое техническое собеседование с экспертом.

VIP-комплект включает персонального ментора, сопровождающего на каждом этапе и разбирающего возникающие вопросы в течение часа. Возможность организовать вместе с наставником дополнительный проект.

Чему научитесь:

- Использовать алгоритмические конструкции и структуры данных Python для проектирования систем анализа информации;

- Собирать данные из веб-источников или по API;

- Визуализировать данные с помощью Pandas, Matplotlib;

- Генерировать модели с помощью машинного и глубокого обучения для решения поступающих задач в рамках Data Science;

- Применять методы статистического и математического анализа, разбираться в основах линейной алгебры и теории вероятности;

- Специализироваться на ML/CV/NLP-инженерии (специальность предстоит выбрать);

- Конвертировать и разбирать бизнес-задачи, распределять обязанности внутри команды;

- Знать Python, писать чистый код, находить и исправлять ошибки.

Как проходит обучение: Основа учебного курса – тесты и интерактивные задания, представленные в личном кабинете в рамках специального тренажера. После каждого занятия и пройденного этапа – дополнительные практические испытания. Знания закрепляются с помощью видеолекций и специальных методических материалов. Финальный этап – обязательная защита диплома.

Преимущества курса:

- Скидки для студентов SkillFactory, оплата обучения в рассрочку, возврат налогового вычета;

- Обучение частично построено в формате ролевого квеста с диалогами и испытаниями, открывающими новые сюжетные повороты;

- Наличие индивидуальных консультаций с экспертами, помощь в оформлении портфолио и поиском подходящих вакансий;

- Возможность стартовать с нуля и дойти до позиции Middle с 10+ работами в портфолио и практическими навыками;

- Полноценная поддержка от экспертов, закрытого сообщества студентов и наставника, разбирающего ошибки;

- Студентам выдаются фундаментальные практические знания, а не синтаксис языка, способный исчезнуть уже через пару лет;

- Наличие групповых проектов для тренировки навыков взаимодействия внутри команды.

Образование в области Data Science: ничего невозможного нет

Сегодня для тех, кто хочет развиваться в сфере анализа больших данных, существует очень много возможностей: различные образовательные курсы, специализации и программы по data science на любой вкус и кошелек, найти подходящий для себя вариант не составит труда. С моими рекомендациями по курсам можно ознакомиться здесь.

Потому как Data Scientist — это человек, который знает математику. Анализ данных, технологии машинного обучения и Big Data – все эти технологии и области знаний используют базовую математику как свою основу.

Читайте по теме: 100 лучших онлайн-курсов от университетов Лиги плюща Многие считают, что математические дисциплины не особо нужны на практике. Но на самом деле это не так.

Приведу пример из нашего опыта. Мы в E-Contenta занимаемся рекомендательными системами. Программист может знать, что для решения задачи рекомендаций видео можно применить матричные разложения, знать библиотеку для любимого языка программирования, где это матричное разложение реализовано, но совершенно не понимать, как это работает и какие есть ограничения. Это приводит к тому, что метод применяется не оптимальным образом или вообще в тех местах, где он не должен применяться, снижая общее качество работы системы.

Хорошее понимание математических основ этих методов и знание их связи с реальными конкретными алгоритмами позволило бы избежать таких проблем.

Кстати, для обучения на различных профессиональных курсах и программах по Big Data зачастую требуется хорошая математическая подготовка.

«А если я не изучал математику или изучал ее так давно, что уже ничего и не помню»? — спросите вы. «Это вовсе не повод ставить на карьере Data Scientist крест и опускать руки», — отвечу я.

Есть немало вводных курсов и инструментов для новичков, позволяющих освежить или подтянуть знания по одной из вышеперечисленных дисциплин. Например, специально для тех, кто хотел бы приобрести знания математики и алгоритмов или освежить их, мы с коллегами разработали специальный курс GoTo Course. Программа включает в себя базовый курс высшей математики, теории вероятностей, алгоритмов и структур данных — это лекции и семинары от опытных практиков

Особое внимание отведено разборам применения теории в практических задачах из реальной жизни. Курс поможет подготовиться к изучению анализа данных и машинного обучения на продвинутом уровне и решению задач на собеседованиях

|

15 сентября в Москве состоится конференция по большим данным Big Data Conference. В программе — бизнес-кейсы, технические решения и научные достижения лучших специалистов в этой области. Приглашаем всех, кто заинтересован в работе с большими данными и хочет их применять в реальном бизнесе. |

Ну а если вы еще не определились, хотите ли заниматься анализом данных и хотели бы для начала оценить свои перспективы в этой профессии, попробуйте почитать специальную литературу, блоги о науке данных или посмотреть лекции. Например, рекомендую почитать хабы по темам Data Mining и Big Data на Habrahabr. Для тех, кто уже хоть немного в теме, со своей стороны порекомендую книгу «Машинное обучение. Наука и искусство построения алгоритмов, которые извлекают знания из данных» Петера Флаха — это одна из немногих книг по машинному обучению на русском языке.

Заниматься Data Science так же трудно, как заниматься наукой в целом. В этой профессии нужно уметь строить гипотезы, ставить вопросы и находить ответы на них. Само слово scientist подталкивает к выводу, что такой специалист должен, прежде всего, быть исследователем, человеком с аналитическим складом ума, способный делать обоснованные выводы из огромных массивов информации в достаточно сжатые строки. Скрупулезный, внимательный, точный — чаще всего он одновременно и программист, и математик.

Data Scientist: кто это и что он делает

В переводе с английского Data Scientist – это специалист по данным. Он работает с Big Data или большими массивами данных.

Источники этих сведений зависят от сферы деятельности. Например, в промышленности ими могут быть датчики или измерительные приборы, которые показывают температуру, давление и т. д. В интернет-среде – запросы пользователей, время, проведенное на определенном сайте, количество кликов на иконку с товаром и т. п.

Данные могут быть любыми: как текстовыми документами и таблицами, так и аудио и видеороликами.

От области деятельности зависят и результаты работы Data Scientist. После извлечения нужной информации специалист устанавливает закономерности, подвергает их анализу, делает прогнозы и принимает бизнес-решения.

Человек этой профессии выполняет следующие задачи: оценивает эффективность и работоспособность предприятия, предлагает стратегию и инструменты для улучшения, показывает пути для развития, автоматизирует нудные задачи, помогает сэкономить на расходах и увеличить доход.

Его труд заканчивается созданием модели кода программы, сформировавшейся на основе работы с данными, которая предсказывает самый вероятный результат.

Профессия появилась относительно недавно. Лишь десятилетие назад она была официально зафиксирована. Но уже за такой короткий промежуток времени стала актуальной и очень перспективной.

Каждый год количество информации и данных увеличивается с геометрической прогрессией. В связи с этим информационные массивы уже не получается обрабатывать старыми стандартными средствами статистики. К тому же сведения быстро обновляются и собираются в неоднородном виде, что затрудняет их обработку и анализ.

Вот тут на сцене и появляется Data Scientist. Он является междисциплинарным специалистом, у которого есть знания статистики, системного и бизнес-анализа, математики, экономики и компьютерных систем.

Знать все на уровне профессора не обязательно, а достаточно лишь немного понимать суть этих дисциплин. К тому же в крупных компаниях работают группы таких специалистов, каждый из которых лучше других разбирается в своей области.

Эти знания помогают ему выполнять свои должностные обязанности:

- взаимодействовать с заказчиком: выяснять, что ему нужно, подбирать для него подходящий вариант решения проблемы;

- собирать, обрабатывать, анализировать, изучать, видоизменять Big Data;

- анализировать поведение потребителей;

- составлять отчеты и делать презентации по выполненной работе;

- решать бизнес-задачи и увеличивать прибыль за счет использования данных;

- работать с популярными языками программирования;

- моделировать клиентскую базу;

- заниматься персонализацией продуктов;

- анализировать эффективность деятельности внутренних процессов компании;

- выявлять и предотвращать риски;

- работать со статистическими данными;

- заниматься аналитикой и методами интеллектуального анализа;

- выявлять закономерности, которые помогают организации достигнуть конечной цели;

- программировать и тренировать модели машинного обучения;

внедрять разработанную модель в производство.

Четких границ требований к Data Scientist нет, поэтому работодатели часто ищут сказочное создание, которое может все и на превосходном уровне. Да, есть люди, которые отлично понимают статистику, математику, аналитику, машинное обучение, экономику, программирование. Но таких специалистов крайне мало.

Еще часто Data Scientist путают с аналитиком. Но их задачи несколько разные. Поясню, что такое аналитика и как она отличается от деятельности Data Scientist, на примере и простыми словами.

В банк пришел клиент, чтобы оформить кредит. Программа начинает обрабатывать данные этого человека, выясняет его кредитную историю и анализирует платежеспособность заемщика. А алгоритм, который решает выдавать кредит или нет, – продукт работы Data Scientist.

Аналитик же, который работает в этом банке, не интересуется отдельными клиентами и не создает технические коды и программы. Вместо этого он собирает и изучает сведения обо всех кредитах, что выдал банк за определенный период, например, квартал. И на основе этой статистики решает, увеличить ли объемы выдачи кредитов или, наоборот, сократить.

Аналитик предлагает действия для решения задачи, а Data Scientist создает инструменты.

Пример: профилактика диабета

Что, если мы сможем предсказать возникновение диабета и предпринять соответствующие меры заранее, чтобы предотвратить его?

В этом случае мы прогнозируем появление диабета, используя весь жизненный цикл, о котором мы говорили ранее. Давайте рассмотрим различные шаги.

Шаг 1:

Во-первых, мы собираем данные на основе истории болезни пациента, как описано в Фазе 1. Вы можете обратиться к приведенным ниже примерам.

Данные

Как вы можете видеть, у нас есть различные атрибуты, как указано ниже.Атрибуты:

npreg — Количество беременности

glucose — Концентрация глюкозы в плазме

bp — Кровяное давление

skin — Толщина кожи трицепса

bmi — Индекс массы тела

ped — Функция родословной диабета

age — Возраст

income — Доход

Шаг 2:

Теперь, как только у нас появились данные, нам необходимо очистить и подготовить их для анализа.

Эти данные имеют множество несоответствий, таких как отсутствующие значения, пустые столбцы, неожиданные значения и неправильный формат данных, которые необходимо очистить.

Здесь мы организовали данные в одну таблицу под разными атрибутами, что делает ее более структурированной.

Давайте посмотрим на примеры ниже.

Очистка данных

Эти данные имеют много несоответствий.

В столбце npreg слово «one» написано словами, тогда как оно должно быть в числовой форме.

В столбце bp одно из значений — 6600, что невозможно (по крайней мере для людей), поскольку bp не может доходить до такого огромного значения.

Как вы можете видеть, столбец «income» пуст, в этом случае не имеет смысла прогнозировать диабет. Поэтому иметь его здесь избыточно и это нужно удалить из таблицы.

Таким образом, мы очистим и обработаем данные, удалив выбросы, заполнив нулевые значения и нормализуя типы данных. Если вы помните, это наш второй этап, который представляет собой предварительную обработку данных.

Наконец, мы получаем чистые данные, как показано ниже, которые можно использовать для анализа.

Очищенные данные

Шаг 3:

Теперь давайте сделаем некоторый анализ, как обсуждалось ранее в Фазе 3.

Сначала мы загрузим данные в аналитическую песочницу и применим к ней различные статистические функции. Например, R имеет такие функции, как describe, которое дает нам количество отсутствующих значений и уникальных значений. Мы также можем использовать summary функцию, которая даст нам статистическую информацию, такую как средние, медианные, диапазонные, минимальные и максимальные значения.

Затем мы используем методы визуализации, такие как гистограммы, линейные графики, полевые диаграммы (histograms, line graphs, box plots), чтобы получить представление о распределении данных.

Data Science визуализация

Шаг 4:

Теперь, основываясь на представлениях, полученных на предыдущем шаге, наилучшим образом подходит для этой проблемы — дерево решений (decision tree).

Поскольку у нас уже есть основные атрибуты для анализа, такие как npreg, bmi и т. Д., Поэтому мы будем использовать метод обучения с учителем для создания модели.

Кроме того, мы использовали дерево решений, потому что оно учитывает все атрибуты за один раз, например, те, которые имеют линейную связь, а также те, которые имеют нелинейную взаимосвязь. В нашем случае мы имеем линейную зависимость между npreg и age, тогда как существует нелинейная связь между npreg и ped.

Модели дерева решений очень надежны, так как мы можем использовать различную комбинацию атрибутов для создания различных деревьев, а затем, наконец, реализовать ту, которая имеет максимальную эффективность.

Давайте посмотрим на наше дерево решений.

Дерево решений

Здесь самым важным параметром является уровень глюкозы, поэтому это наш корневой узел. Теперь текущий узел и его значение определяют следующий важный параметр. Это продолжается до тех пор, пока мы не получим результат в терминах pos или neg. Pos означает, что тенденция к диабету является положительной, а neg отрицательной.

Шаг 5:

На этом этапе мы проведем небольшой пилотный проект, чтобы проверить, соответствуют ли между собой наши результаты. Мы также будем искать ограничения производительности, если таковые имеются. Если результаты неточны, нам нужно перепланировать и перестроить модель.

Шаг 6:

Как только мы выполним проект успешно, мы будем делиться результатами для полного развертывания.

Data Scientist’у проще сказать, чем сделать. Итак, давайте посмотрим, что вам нужно, чтобы быть им. Data Science требует навыков в основном из трех основных областей, как показано ниже.

Data Science умения и навыки

Как вы можете видеть на приведенном выше графике, вам нужно приобрести различные умения и навыки. Вы должны хорошо разбираться в статистике и математике для анализа и визуализации данных.

Требования к специалисту

Специалист по данным неразрывно связан с Data Science – наукой о данных. Она находится на пересечении нескольких направлений: математики, статистики, информатики и экономики. Следовательно, специалисты должны понимать и интересоваться каждой из этих наук.

Кроме этого, Data Scientist должен знать:

- Языки программирования для того, чтобы писать на них код. Самые распространенные – это SAS, R, Java, C++ и Python.

- Базы данных MySQL и PostgreSQL.

- Технологии и инструменты для представления отчетов в графическом формате.

- Алгоритмы машинного и глубокого обучения, которые созданы для автоматизации повторяющихся процессов с помощью искусственного интеллекта.

- Как подготовить данные и сделать их перевод в удобный формат.

- Инструменты для работы с Big Data: Hadoop, MapReduce, Apache Hive, Apache Kafka, Apache Spark.

- Как установить закономерности и видеть логические связи в системе полученных сведений.

- Как разработать действенные бизнес-решения.

- Как извлекать нужную информацию из разных источников.

- Английский язык для чтения профессиональной литературы и общения с зарубежными клиентами.

- Как успешно внедрить программу.

- Область деятельности организации, на которую работает.

Помимо того, что специалист по данным должен обладать аналитическим и математическим складом ума, он также должен быть:

- трудолюбивым,

- настойчивым,

- скрупулезным,

- внимательным,

- усидчивым,

- целеустремленным,

- коммуникабельным.

Хочу отметить, что гуманитариям достичь высот в этой профессии будет крайне тяжело. Только при большом желании можно пробовать осваивать данную стезю.

Как начать?

Новичкам без бэкграунда в IT попасть в профессию сложно, так как она требует серьезной технической подготовки: нужно писать хотя бы на Python, владеть инструментами автоматизации.

Для специалиста в этой области важны знания алгоритмов и структур данных. Алгоритмические задачи хорошо выстраивают мышление, знание синтаксиса языка и его возможностей. Алгоритмы данных можно изучить на бесплатном курсе на Coursera.

Кроме того, на Coursera можно познакомиться с базовыми понятиями, научиться строить пайплайны (выстраивать весь ETL-процесс переноса данных из одного места в другое), разобраться в том, что такое базы данных и как устроены системы облачных хранилищ.

Можно попробовать самостоятельно определить траекторию обучения, ориентируясь на Road map профессии. C ее помощью удобно систематизировать, какими навыками вы уже овладели, а какие нужно подтянуть или выучить с нуля.

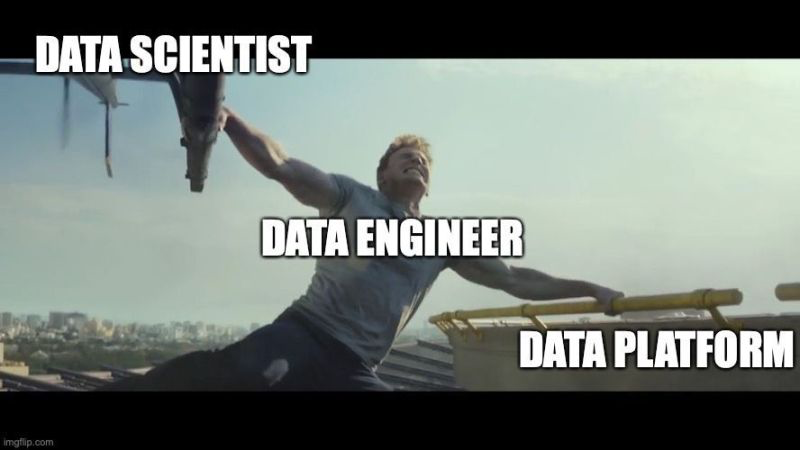

Что делает дата-инженер?

Дата-инженер (Data Engineer) участвует в начальной и финальной стадиях анализа данных, обеспечивает их работу на инфраструктуре компании. Он занимается ETL-процессами, то есть обрабатывает данные: достает (extract) их из сырых источников, трансформирует (transform) и загружает (load).

После предварительной обработки, очистки от повторов, ошибок, ненужных уточнений, он автоматизирует выполнение скриптов и, если нужно, настраивает мониторинги, алерты (сигналы о том, что в моделях что-то пошло не так), задает расписание, по которому сервис или программа будут работать с данными (шедуллит).

Задачи в компаниях могут отличаться: где-то инженер только обрабатывает данные, а где-то выполняет и программистскую работу: внедряет новые модели и переучивает старые.

Помимо сбора и обработки дата-инженер организует хранение данных. Для этого он строит архитектуру хранилищ – базы данных с таблицами, в которых они разбиты по смыслу. Дата-сайентистам это облегчает доступ к обработанным наборам данных (признакам), с помощью хранилища проще и быстрее масштабировать модели.

Дата-сайентист / дата-инженер / платформа управления данными, Источник

Как дела обстоят у нас

Мы создаем систему городской мобильности с человеческим отношением к пассажирам и водителям. И хотим сделать это отраслевым стандартом. Хотим встречать и провожать пассажиров в аэропорты и на вокзалы; доставлять важные документы по указанным адресам быстрее курьеров; сделать так, чтобы на такси было не страшно отправить ребёнка в школу или девушку домой после свидания, даем возможность выбрать транспорт — каршеринг, такси или самокат. И даже если нашим пассажиром является котик, то ему должно быть максимально комфортно.

У нас есть большой отдел эффективности платформы (или Marketplace), где в каждом из направлений работают специалисты по обработке и анализу данных.

-

Ценообразование: правильный и правдоподобный предрасчет цены для клиента на предстоящую поездку. Мы разрабатываем алгоритмы, которые тонко настраивают наши цены под специфические региональные и временные условия, а также помогают нам держать вектор оптимального ценового роста и развития

-

Клиентские мотивации: помогают нам привлекать новых клиентов, удерживать старых и делать нашу цену самой привлекательной на рынке. Основное направление — это разработка алгоритма оптимального распределения бюджета на скидки клиентам для достижения максимального количества поездок. Мы стремимся создать выгодное предложение для каждого клиента, поддержать и ускорить наш рост

-

Водительские мотивации: одна из главных задач Ситимобил — забота о водителях. Наши алгоритмы создают для них среду, в которой каждый работает эффективно и зарабатывает много. Мы стремимся разработать подход, позволяющий стимулировать водителей к выполнению поездок там, где другие алгоритмы не справляются: возмещаем простой на линии, если нет заказов, и гарантируем стабильность завтрашнего дня для привлечения всё новых и новых водителей.

-

Динамическое ценообразование: главная задача направления — гарантировать возможность уехать на такси в любое время и в любом месте. Достигается это за счет кратковременного изменения цен, когда желающих уехать больше, чем водителей в определенной гео-зоне.

-

Распределение заказов: эффективные алгоритмы назначения водителей на заказ уменьшают длительность ожидания и повышают заработок водителей. Задача этого направления — создать масштабируемые механизмы назначения, превосходно работающие как в целом по городам, так и в разрезе каждого тарифа.

-

Исследование эффективности маркетплейсов: центральное аналитическое направление, задачей которого является анализ эффективного баланса между количеством водителей на линии и пассажирами.

-

ГЕО сервисы: эффективное использование геоданных помогает различным командам эффективно настраивать свои алгоритмы, которые напрямую зависят от качества этих данных. Мы стремимся создавать такие модели, сервисы и алгоритмы, которые не только повышают качество маршрутизации и гео-поиска, но и напрямую воздействуют на бизнес, а также клиентский опыт.

Что изучает Data Science

Каждый день человечество генерирует примерно 2,5 квинтиллиона байт различных данных. Они создаются буквально при каждом клике и пролистывании страницы, не говоря уже о просмотре видео и фотографий в онлайн-сервисах и соцсетях.

Наука о данных появилась задолго до того, как их объемы превысили все мыслимые прогнозы. Отсчет принято вести с 1966 года, когда в мире появился Комитет по данным для науки и техники — CODATA. Его создали в рамках Международного совета по науке, который ставил своей целью сбор, оценку, хранение и поиск важнейших данных для решения научных и технических задач. В составе комитета работают ученые, профессора крупных университетов и представители академий наук из нескольких стран, включая Россию.

Сам термин Data Science вошел в обиход в середине 1970-х с подачи датского ученого-информатика Петера Наура. Согласно его определению, эта дисциплина изучает жизненный цикл цифровых данных от появления до использования в других областях знаний. Однако со временем это определение стало более широким и гибким.

Data Science (DS) — междисциплинарная область на стыке статистики, математики, системного анализа и машинного обучения, которая охватывает все этапы работы с данными. Она предполагает исследование и анализ сверхбольших массивов информации и ориентирована в первую очередь на получение практических результатов.

В 2010-х годах объемы данных по экспоненте. Свою роль сыграл целый ряд факторов — от повсеместного распространения мобильного интернета и популярности соцсетей до всеобщей оцифровки сервисов и процессов. В итоге профессия дата-сайентиста быстро превратилась в одну из самых популярных и востребованных. Еще в 2012 году позицию дата-сайентиста журналисты назвали самой привлекательной работой XXI века (The Sexiest Job of the XXI Century).

Объем данных, созданных, собранных и потребленных во всем мире с 2010 по 2024 год (в зеттабайтах)

(Фото: Statista)

Развитие Data Science шло вместе с внедрением технологий Big Data и анализа данных. И хотя эти области часто пересекаются, их не следует путать между собой. Все они предполагают понимание больших массивов информации. Но если аналитика данных отвечает на вопросы о прошлом (например, об изменениях в поведениях клиентов какого-либо интернет-сервиса за последние несколько лет), то Data Science в буквальном смысле смотрит в будущее. Специалисты по DS на основе больших данных могут создавать модели, которые предсказывают, что случится завтра. В том числе и предсказывать спрос на те или иные товары и услуги.

2017: Высшая школа экономики будет обучать Data Culture на всех программах бакалавриата

НИУ ВШЭ первым из российских университетов начнет формировать компетенции по Data Science у всех студентов, обучающихся на программах бакалавриата. В рамках проекта Data Culture расширится набор дисциплин и появятся образовательные треки по анализу больших данных.

Data Culture – это общий термин для обозначения навыков и культуры работы с данными. Высшая школа экономики считает, что запуск проекта, направленного на воспитание у студентов таких навыков, сейчас актуален из-за огромного потенциала использования больших данных и трансформации профессий, которые, так или иначе, используют или могут использовать большие массивы информации. Потребность рынка в специалистах с компетенциями по анализу данных, перерастает в необходимость воспитания во всех предметных областях профессионалов, понимающих возможности и ограничения массивов данных, потенциал и особенности методов машинного обучения, а в ряде направлений и умеющих пользоваться этими технологиями и инструментами.

Проект Data Culture станет продолжением интеграции в образовательные программы НИУ ВШЭ элементов, направленных на воспитание у студентов культуры и умений работы с данными. Он расширит возможности студентов уже абсолютно всех образовательных программ по формированию компетенций, связанных с Data Science. Это позволит выпускникам в перспективе быстро и эффективно интегрироваться в решение профессиональных задач на стыке предметных областей и компьютерных технологий, которые сегодня являются передовыми, но уже в ближайшей перспективе станут привычной практикой.

Проект включает разработку отдельных курсов по Data Science так или иначе кастомизированных под специфику образовательных программ, а также формирование специализированных образовательных треков из таких курсов с разной степенью сложности: начального, базового, продвинутого, профессионального и экспертного уровней. Это связано с большим разнообразием образовательных программ, студенты которых дифференцированы по базовым компетенциям в сфере математики и информатики. Для программ или их блоков будет предложена система курсов Data Culture в определенной вилке «сквозного уровня продвинутости». Более того, эти системы курсов определятся спецификой предметных областей.

Внедрение дисциплин Data Culture будет происходить поэтапно. В 2017/2018 учебном году будут включены в учебные планы обязательные и элективные курсы по направлению Data Science для части образовательных программ, но таковых будет более половины. Например, у студентов-гуманитариев, юристов и дизайнеров появится вводный курс по цифровой грамотности, программы экономистов дополнятся дисциплиной по машинному обучению, политологов – анализу социальных сетей, у статистиков появится курс по программированию и извлечению и анализу интернет-данных. С 2018 года к проекту примкнут все образовательные программы.

Для реализации проекта Data Culture предполагается привлечение преподавательского состава как из академической среды (преподаватели факультета компьютерных наук, сотрудники департамента математики факультета экономических наук и общеуниверситетской кафедры высшей математики и т.д.), так и из индустрии (участники сообществ по анализу данных, участники тематических мероприятий по анализу данных, проводимых в IT-компаниях). Более того, преподаватели факультетов, которые уже погружены в работу с данными в рамках своей профессиональной деятельности, также будут разрабатывать курсы в рамках проекта Data Culture для студентов своих и смежных факультетов.