Как добавить сайт на индексацию поисковикам

Содержание:

- Robots.txt

- Как проверить индексацию сайта

- Как подготовить сайт к индексации?

- Как индексирует сайты Гугл и Яндекс

- Как закрыть сайт от индексации

- Как подготовить сайт к индексации?

- Почему не индексируется сайт?

- «Яндекс» и Google не знает о вашем сайте

- Сайт или страницы закрыты от индексации в файле robots.txt

- Настройки приватности

- Сайт закрыт от поисковых роботов в мета-тегах

- Ошибки сканирования

- Сайт закрыт от роботов в .htaccess

- Нестабильная работа сервера или хостинга

- Проблемы с индексацией AJAX/JavaScript

- Дубли контента внутри сайта

- Плохая скорость загрузки

- Домен с баном

- Отсутствует sitemap

- Индексация сайта в Google и Яндекс

- Быстрая индексация в Google

- Особенности индексирования сайтов с разными технологиями

- Страница попала в индекс, но трафика нет, что делать?

- Пояснение терминов «индексация сайта» и «поисковый индекс»

- Скорость индексации

Robots.txt

Это файл, который можно отредактировать в любом текстовом редакторе. Преимущество и одновременно необходимость состоим в том, что он прописывает строгие инструкции для роботов поиска различных поисковых систем. Располагают роботс.тхт в корневой папке сайта.

Наиболее популярные ошибки, возникающие при работе с данным файлом:

-

закрытие действительно нужных страниц сайта. Чаще всего эта ошибка связана с незнанием всех аспектов и нюансов правильного заполнения;

-

использование кириллических символов в файле не допускается;

-

одни и те же правила для разных роботов. Нюанс, о котором часто забывают. Согласитесь, что даже на вид «Яндекс» и «Google» сильно отличаются друг от друга. Что тогда говорить о внутренних алгоритмах ранжирования и поисковых роботах?! Соответственно, и правила надо прописывать разные, так как один бот их примет, а другой даже не обратит внимания, а может и сразу уйдет, не завершив процесс индексирования.

-

использование директивы «crawl-delay» (определяет частоту запросов поискового бота и часто используется в тех случаях, когда сервер подвержен сильной нагрузке) без необходимости. Реальный пример: был сайт-визитка на самом дешевом хостинге. В него добавили каталог, содержащий около 10 000 товаров. Робот-поисковик начал скачивать и анализировать информацию и из-за ее объема стал не успевать ее обрабатывать. Многие страницы стали недоступны, выдавая 404-ую ошибку. Логичное решение – выставить директиву «crawl-delay». Поставили, все начало работать. Затем, в связи с разрастанием сайта, было решено перенести веб-ресурс на другой хостинг-провайдер, учтя при этом заранее параметры нагрузки сервера. Вроде все замечательно, а директиву «кроул» убрать забыли!!! В результате нагрузка на сервер минимальная, робот «не спешит» все обрабатывать и на выходе – очень долгое время индексации сайта.

Проверить файл с инструкциями для роботов можно, используя сервисы вебмастера от «Яндекс» или «Гугл». В «Yandex.Webmaster» достаточно зайти в раздел «Инструменты», затем в «анализ robots.txt». Загрузить файл и его вставить непосредственно в поле, посмотреть рекомендации или ошибки, которые необходимо будет исправить.

Как проверить индексацию сайта

Проверка индексации сайта осуществляется несколькими способами:

1. Через оператор site: в Google и Яндекс. Этот оператор не дает исчерпывающий список страниц, но даст общее понимание о том, какие страницы в индексе. Выдает результаты по основному домену и поддоменам.

2. Через Google Search Console и Яндекс.Вебмастер. В консоли вашего сайта есть детальная информация по всем страницам ― какие из них проиндексированы, какие нет и почему.

У Яндекса в Вебмастере тоже есть информация по добавленным страницам в индекс и исключенным и по каким причинам — в разделе «Индексирование ⇒ Страницы в поиске».

3. Воспользоваться плагинами для браузера типа RDS Bar или специальными инструментами для проверки индексации. Например, узнать, какие страницы вашего сайта попали в индекс поисковика можно в инструменте «Проверка индексации» SE Ranking.

Для этого достаточно ввести нужную вам поисковую систему (Google, Яндекс, Yahoo, Bing), добавить список урлов сайта и начать проверку. Чтобы протестировать работу инструмента «Проверка индексации», зарегистрируйтесь на платформе SE Ranking и откройте тул в разделе «Инструменты».

В этом месте вы можете поднять руку и спросить «А что, если у меня сайт на AJAX? Он попадет в индекс?». Отвечаем

Как подготовить сайт к индексации?

Сделать это можно путем его внутренней и внешней оптимизации. В частности, необходимо сделать следующее:

Выбрать правильное имя для домена. Лучше всего, если в его название будет входить главное ключевое слово. Желательная длина – до 12 символов.

Выбрать надежный хостинг. Он должен быть быстрым и понятным, работать без перебоев и не мешать индексации. Один из лучших – beget.ru.

Использовать адаптивный дизайн. Если вы используете шаблон, смотрите, чтобы он хорошо отображался на планшетах, мобильниках и компьютерах. В нем также не должно быть никаких скрытых ссылок.

Создать Robots.txt. Этот файл показывает роботам, какие страницы можно, а какие нельзя индексировать. Настройка сложная, поэтому лучше доверить ее специалистам.

Создать карту сайта. Даже две: первая должна быть в формате .xml (для поисковых ботов), вторая — в .html (для людей). Сделать их легче. Для составления карт даже придуманы специальные плагины. Например, на WordPress это WP Sitemap Page и небезызвестный опытным веб-мастерам Google XML Sitemaps от Arne Brachhold.

Составить семантическое ядро (СЯ) – это такой список из поисковых фраз, по которым в дальнейшем ваш сайт будут находить пользователи. В принципе, эту работу нужно проделать до регистрации домена и хостинга. И, естественно, еще до проверки индексации сайта в поисковиках.

Написать тексты с учетом слов из СЯ и оптимизировать картинки. Статьи следует писать оптимизированные, не забывая про новый алгоритм от «Яндекса» «Королев». Изображения до загрузки на ресурс желательно сжимать без потери качества. Сделать это можно с помощью специальных сервисов.

Прописать все важные мета-теги. В частности, Title (название статьи, длина – до 80 символов) и Description (краткое описание, длина – до 200 символов)

В дескрипшен важно включить самое главное ключевое слово в разбавленном виде.

Оставить ссылки на авторитетных ресурсах (внешняя оптимизация!). Тут только 2 правила: сайт-донор должен быть действительно тематическим, а ссылка — вечной.

Создать группу для сайта в соц.сетях и размещать ссылки на новые посты там.

Подтвердить права на свой ресурс и поставить его в очередь на индексирование

Сделать это можно через панель веб-мастера Yandex или «Гугла».

Еще перед тем, как проверить индексацию сайта «Яндексом», нужно ускорить загрузку ресурса. Все рекомендации по тому, что для этого можно сделать, стоит смотреть на developers.google.com/speed/ или ином аналогичном ресурсе.

Как индексирует сайты Гугл и Яндекс

Яндекс и Гугл, пожалуй, самые популярные поисковики в России. Чтобы поисковые системы проиндексировали сайт, о нем нужно сообщить. Сделать это можно двумя способами:

- Добавить сайт на индексацию при помощи ссылок на других ресурсах в интернете — этот способ считается оптимальным, так как страницы, найденные таким путем, робот считает полезными и их индексирование проходит быстрее, от 12 часов до двух недель.

- Отправить сайт на индексацию путем заполнения специальной формы поисковой системы вручную с использованием сервисов Яндекс.Вебмастер, Google Webmaster Tools, Bing Webmaster Tools и др.

Второй способ медленнее, сайт встает в очередь и индексируется в течение двух недель или больше.

В среднем, новые сайты и страницы проходят индексацию за 1–2 недели.

Считается, что Гугл индексирует сайты быстрее. Это происходит потому, что поисковая система Google индексирует все страницы — и полезные, и неполезные. Однако в ранжирование попадает только качественный контент.

Яндекс работает медленнее, но индексирует полезные материалы и сразу исключает из поиска все мусорные страницы.

Индексирование сайта происходит так:

- поисковый робот находит портал и изучает его содержимое;

- полученная информация заносится в базу данных;

- примерно через две недели материал, успешно прошедший индексацию, появится в выдаче по запросу.

Есть 3 способа проверки индексации сайта и его страниц в Гугл и Яндексе:

- при помощи инструментов для вебмастеров — google.com/webmasters или webmaster.yandex.ru;

- при помощи ввода специальных команд в поисковую строку, команда для Яндекс будет выглядеть так: host: имя сайта+домен первого уровня; а для Гугл — site: имя сайта+домен;

- с помощью специальных автоматических сервисов.

Как закрыть сайт от индексации

Закрыть сайт от индексации — запретить поисковым роботам доступ к сайту, к некоторым его страницам, части текста или изображению. Обычно это делается для того, чтобы скрыть от публичного доступа секретную информацию, технические страницы, сайты на уровне разработки, дублированные страницы и т. п.

Сделать это можно несколькими способами:

При помощи robots.txt можно запретить индексацию сайта или страницы. Для этого в корне веб-сайта создается текстовый документ, в котором прописываются правила для роботов поисковых систем. Эти правила состоят из двух частей: первая часть (User-agent) указывает на адресата, а вторая (Disallow) запрещает индексацию какого-либо объекта.

Например, запрет индексации всего сайта для всех поисковых ботов выглядит так:

User-agent: *

Disallow: /

При помощи мета-тега robots, что считается наиболее правильным для закрытия одной страницы от индексирования. При помощи тегов noindex и nofollow можно запретить роботам любых поисковых систем индексировать сайт, страницу или часть текста.

Запись для запрета индексации всего документа будет выглядеть так:

<meta name=»robots» content=»noindex, nofollow»/>

Можно создать запрет для конкретного робота:

<meta name=»googlebot» content=»noindex, nofollow»/>

Как подготовить сайт к индексации?

Сразу стоит отметить, что крайне нежелательно выкладывать сайт на стадии разработки. Поисковые системы могут проиндексировать неоконченные страницы с некорректными сведениями, орфографическими ошибками и т. д. В итоге это негативно отразится на рейтинге сайта и выдаче информации с этого ресурса в поиске.

Теперь давайте перечислим моменты, о которых нельзя забывать на этапе подготовки ресурса к индексации:

- на flash файлы распространяются ограничения индексации, поэтому сайт лучше создавать с помощью HTML;

- такой тип данных, как Java Script также не индексируется поисковыми роботам, в связи с этим навигацию по сайту следует дублировать текстовыми ссылками, а всю важную информацию, которая должна быть проиндексирована, не пишем в Java Script;

- нужно убрать все неработающие внутренние ссылки так, чтобы каждая ссылка вела на реальную страницу вашего ресурса;

- структура сайта должна позволять с легкостью переходить от нижних страниц к главной и обратно;

- лишние и второстепенные сведения и блоки лучше переместить к низу страницы, а также скрыть их от ботов специальными тегами.

Почему не индексируется сайт?

Бывают ситуации, когда вебмастер ведет работу над SEO-оптимизацией сайта: активно наполняет его контентом, наращивает ссылки, а количество страниц в поисковой выдаче Google или «Яндекс» не увеличивается. Или что еще хуже — в поиске нет ни одного документа с сайта. С чем это связано? Самые распространенные причины:

«Яндекс» и Google не знает о вашем сайте

Если это новый ресурс, и вы только недавно открыли его для поисковых роботов, то, возможно, они просто его еще не нашли. Но эту проблему легко решить, выполнив несколько простых манипуляций:

- Добавить сайт в «Яндекс.Вебмастер» и Google Webmasters.

- Направить поисковых роботов на страницы сайта.

В «Яндекс.Вебмастер» («Индексирование» — «Переобход страниц»):

В Google Webmasters («Проверить URL» — Добавить адрес страницы — «Запросить Индексирование»):

Нужно будет немного подождать, пока робот обойдет страницы сайта. Как правило, на это уходит 1-2 часа (хотя может затянуться на несколько дней).

Сайт или страницы закрыты от индексации в файле robots.txt

Порой вебмастера, работая над сайтом, забывают открыть его для индексации. Но это легко исправить. Добавьте следующую команду в файл:

Это означает, что ресурс открыт для всех поисковых роботов. Но не забывайте, что нужно закрыть дубли на сайте, ведь не все содержимое должно принимать участие в поиске. Поэтому уделите заполнению файла robots.txt достаточно времени.

Настройки приватности

Если сайт управляется CMS WordPress, то по умолчанию в нем выставлены настройки приватности, которые запрещают индексацию поисковыми роботами. Авторизуйтесь в админке, перейдите в «Настройки — Чтение — Видимость для поисковых систем» и снимите галочку:

Сайт закрыт от поисковых роботов в мета-тегах

Запретить индексировать содержание страниц можно и с помощью мета-тега:

Как решить проблему:

- Посмотрите, нет ли такого тега на странице.

- Удалите код или добавьте другие мета-теги follow и index.

Ошибки сканирования

Проблемы с индексацией возникают и в том случае, если робот, обращаясь к ресурсу, не может просканировать его содержимое.

Проверьте все ли в порядке:

- Авторизуйтесь в Google Webmaster.

- Откройте «Сканирование» — «Ошибки сканирования»:

В идеале не должно быть никаких ошибок.

Сайт закрыт от роботов в .htaccess

В этом файле содержится правило 301 редиректа. Но помимо него, может быть прописана команда не индексировать сайт.

Чтобы проверить, выполните следующее:

- Найдите и откройте файл файл .htaccess на сервере.

- Проанализируйте содержимое кода.

Нестабильная работа сервера или хостинга

Выбирайте стабильный хостинг с хорошей репутацией. В противном случае, если роботы будут обращаться к сайту, он будет часто недоступен, а их попытки станут все реже. Через некоторое время они и вовсе откажутся заходить к вам на сайт.

Проблемы с индексацией AJAX/JavaScript

Поисковым роботам сложнее просканировать содержимое AJAX и JavaScript, чем HTML. Если вы допустите ошибки при оптимизации, то Google и «Яндекс» не проиндексируют определенные страницы или даже весь сайт.

Дубли контента внутри сайта

За дублирование контента поисковые системы наказывают санкциями, но это тоже одна из причин плохой индексации. К дублям может относиться одинаковый контент, открывающийся на разных страницах, мета-теги или даже страницы, если они доступны под двумя адресами (с www и без; http и https). Если не исправить проблему своевременно, то она негативно скажется на дальнейшем SEO-продвижении.

Плохая скорость загрузки

При плохой скорости загрузки ресурса, он может плохо индексироваться и потерять позиции, так как этот показатель относится к факторам ранжирования. Проверить насколько быстро загружается ваш сайт можно с помощью специального инструмента — Google Page Speed:

Поработайте над улучшением скорости загрузки сайта, учитывая рекомендации инструмента.

Домен с баном

Случается, что вебмастер выбирает и регистрирует созвучное имя для сайта, наполняет ресурс и ждет, когда он проиндексируется, но ничего не происходит. После анализа домена, выясняется, что домен ранее использовался и находится в бане поисковых систем.

Исправить такую ситуацию не просто. Придется написать в тех. поддержку «Яндекс», чтобы они пересмотрели ресурс или указали причину бана (если вы ее не знаете). Заниматься ли развитием сайта на этом домене — решать вам. Ориентируйтесь на то, что ответит вам техническая поддержка. Часто бывает проще начать все на новом домене.

Отсутствует sitemap

Не самая распространенная причина плохой индексации, но не стоит ее исключать. Создайте карту сайта и не забудьте добавить ее в сервисы для вебмастеров от Google и «Яндекс»:

В «Гугл вебмастер»:

Индексация сайта в Google и Яндекс

Принципы индексации у этих поисковых систем преимущественно одинаковые: краулинг → очистка → индексация → ранжирование. Но различия можно найти, поэтому расскажем о тех, которые известны.

Индексация в Google

Самое главное отличие — Google лучше ориентируется в англоязычном сегменте, то есть лучше воспринимает текст и запрос пользователя на английском. Разница на момент 2020, думается, незначительная, но учитывать стоит.

У Гугла 2 основных типа роботов: для мобильных сайтов и для десктопных. Новые сайты индексируются мобильными роботами и приоритет отдан мобильным версиям сайта, согласно алгоритму mobile-first индекс.

Скорость индексации обычно выше, чем у Яндекса: на 1 страницу уходит неделя или меньше. Индекс обновляется постоянно, а некачественные страницы не удаляются из него, но при этом и не показываются пользователям.

Индексация в Яндексе

У Яндекса тоже 2 типа роботов: основной и быстрый (Orange). Основной робот занимается индексацией всего интернета, а быстрый отвечает за поиск самых свежих документов, чтобы информация была доступна как можно быстрее (от нескольких минут до пары секунд).

Обновление индекса происходит раз в несколько дней ночью, когда нагрузки на серверы меньше. Процесс индексирования сайта обычно занимает от недели до месяца, а некачественные страницы удаляются из индекса.

Как проверить индексацию?

Уточним сразу пару моментов. Индексацию нужно проверять как в Google, так и в Яндексе. Более того, вы должны знать изначальное количество страниц на сайте. Это можно сделать с помощью краулеров типа Xenu, Screaming Frog, Netpeak Spider и других.

Как проверить индексацию:

- Инструменты Яндекс Вебмастер и Google Search Console. В Вебмастере это Индексирование → Страницы поиска (отдельные страницы смотрите в инструменте «Проверить статус URL»). В Search Console откройте отчёт Покрытие → Страницы без ошибок (индексацию отдельных страниц ищите в Проверке URL).

- Используйте оператор site. В поисковой строке Яндекса и Google введите site:name.com, где name — домен сайта. Под строкой поиска справа будет указано количество проиндексированных страниц. Если разница в количестве больше 10%, у вас проблемы с индексацией.

- RDS Bar и другие сервисы. RDS Bar — это бесплатный плагин для браузера. В нём вы узнаете не только количество проиндексированных страниц, но и получите другую полезную информацию. Также автор статьи советует воспользоваться сервисом a.pr-cy. Он позволяет провести хороший первичный аудит сайта и уже в самом начале выявить основные проблемы.

Быстрая индексация в Google

1. Google Webmaster

После появления нового материала на сайте, необходимо добавить ссылку на него в файл sitemap.xml. И отправить карту сайта Google через аккаунт в GWT. Еще одной полезной фишкой данного сервиса является возможность отправки URL новой страницы непосредственно на индексацию. Вы сообщаете Google, что у вас появилась новая страница (даете ссылку) и робот в ближайшее время ее проиндексирует.

Как это сделать?

Заходите в аккаунт Google Webmaster и выбираете в меню «посмотреть как Googlebot». Далее указываете ссылку на новую страницу и нажимаете «Получить и отобразить». Google просканирует страницу и отобразит результат в графе «статус».

Если все прошло успешно, у Вас появится действующая кнопка «Добавить в индекс», туда и жмем. Откроется вот такое окно:

Здесь можно выбрать 2 варианта:

- Сканировать только этот URL. Будет проиндексирована только данная страница. Лимит 500 страниц в неделю

- Сканировать этот URL и прямые ссылки. В этом случае будут добавлены в индекс и те страницы, на которые идут ссылки с указанного URL. Лимит 10 в месяц.

Гарантий индексации это не дает. Но если информация на странице полезная, все требования поисковой системы к качеству соблюдаются – считайте она в индексе.

2. Социальные сети

Еще один очень популярный и действенный способ ускорения индексации в Google – это добавление ссылок в соц.сети. Лучше всего в этом вопросе помогает Twitter

Важно, чтобы указанная ссылка не просто появилась в Twitter, а распространялась. Поэтому у Вашего аккаунта должно быть как можно больше подписчиков, иначе получить желаемый результат не получится

Полезная фишка данного способа – хэштеги. Если Вы найдете популярный хэштег дня, подходящий к теме Вашей статьи (хотя бы отдаленно), Ваш пост будет более популярным

Значит, и поисковый робот быстрее обратит свое внимание на ссылку

3. RSS

Установите на наиболее обновляемые разделы сайта RSS канал. Так робот сможет отслеживать все новые публикации. Есть специальные сервисы для работы с RSS, например, FeedBurner. Этот сервис принадлежит Google, поэтому его добавление на сайт не останется незамеченным. Но помимо ускорения индексации, FeedBurner может исправить ошибки в RSS ленте, чтобы она корректно отображалась у всех пользователей.

Фишка в том, чтобы совместить Twitter и RSS. То есть, настраиваем кросспостинг из RSS в Twitter и ускоряем процесс индексации. Да и подписчики Ваши будут быстрее узнавать об обновлениях.

4. Перелинковка

О пользе правильной перелинковки уже говорилось много раз. Мы решили добавить ее в список лишь как напоминание. Если у Вас крупный многостраничный сайт – без нее индексация будет очень затрудняться. Позаботьтесь о правильной перелинковке сайта в первую очередь. Иначе все остальные труды по ускорению индексации будут напрасны.

Особенности индексирования сайтов с разными технологиями

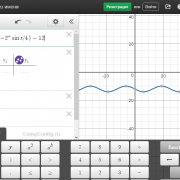

Ajax

Сегодня все чаще встречаются JS-сайты с динамическим контентом ― они быстро загружаются и удобны для пользователей. Одно из основных отличий таких сайтов на AJAX — все содержимое подгружается одним сплошным скриптом, без разделения на страницы с URL. Вместо этого ― страницы с хештегом #, которые не индексируются поисковиками. Как следствие — вместо URL типа https://mywebsite.ru/#example поисковый робот обращается к https://mywebsite.ru. И так для каждого найденного URL с #.

В этом и кроется сложность для поисковых роботов, потому что они просто не могут «считать» весь контент сайта. Для поисковиков хороший сайт ― это текст, который они могут просканировать, а не интерактивное веб-приложение, которое игнорирует природу привычных нам веб-страниц с URL.

Буквально пять лет назад сеошники могли только мечтать о том, чтобы продвинуть такой сайт в поиске. Но все меняется. Уже сейчас в справочной информации и Google, и Яндекс есть данные о том, что нужно для индексации AJAX-сайтов и как избежать ошибок в этом процессе.

Сайты на AJAX с 2019 года рендерятся Google напрямую — это значит, что поисковые роботы сканируют и обрабатывают #! URL как есть, имитируя поведение человека. Поэтому вебмастерам больше не нужно прописывать HTML-версию страницы.

Но здесь важно проверить, не закрыты ли скрипты со стилями в вашем robots.txt. Если они закрыты, обязательно откройте их для индексирования поисковыми роботам

Для этого в robots.txt нужно добавить такие команды:

Поисковые роботы Яндекса тоже могут индексировать сайты на AJAX, но при одном условии ― если у каждой страницы сайта есть HTML-версия. В справочнике Яндекса можно узнать подробнее, как сообщить роботу об HTML-версии страницы.

Флеш-контент

С помощью технологии Flash, которая принадлежит компании Adobe, на страницах сайта можно создавать интерактивный контент с анимацией и звуком. За 20 лет своего развития у технологии было выявлено массу недостатков, включая большую нагрузку на процессор, ошибки в работе флеш-плеера и ошибки в индексировании контента поисковиками.

В 2019 году Google перестал индексировать флеш-контент, ознаменовав тем самым конец целой эпохи. Поисковые роботы Яндекса индексируют только тот текст во Flash-документах, который размещен в таких блоках: DefineText; DefineText2; DefineEditText; Metadata.

Поэтому не удивительно, что поисковики предлагают не использовать Flash на ваших сайтах. Если же дизайн сайта выполнен с применением этой технологии, сделайте и текстовую версию сайта. Она будет полезна как пользователям, у которых не установлена совсем или установлена устаревшая программа отображения Flash, пользователям мобильных устройств (они не отображают flash-контент), так и поисковым роботам Яндекса.

Фреймы

Фрейм это HTML-документ, который не содержит собственного контента, а состоит из разных областей ― каждая с отдельной веб-страницей. Также у него отсутствует элемент BODY.

Как результат, поисковым роботам просто негде искать полезный контент для сканирования. Страницы с фреймами индексируются очень медленно и с ошибками.

Вот что известно от самих поисковиков: Яндекс индексирует контент внутри тегов <frameset> и <frame> и не индексирует документы, подгружаемые в тег <iframe>. А вот Google может индексировать контент внутри встроенного фрейма iframe. Именно iframe поддерживается современными технологиями, так как он позволяет встраивать фреймы на страницы без применения тега <iframe>.

А вот теги <frame>, <noframes>, <frameset> устарели и уже не поддерживаются в HTML5, поэтому и не рекомендуется использовать их на сайтах. Ведь даже если страницы с фреймами будут проиндексированы, то трудностей в их продвижении вам все равно не избежать.

Страница попала в индекс, но трафика нет, что делать?

После добавления сайта в поисковую выдачу каждая страница соревнуется с миллионами подобных страниц с других ресурсов. Чтобы получать хороший поисковый трафик, следует сделать сайт релевантным запросам пользователей и удобным для них.

Начинаем с заполнения тегов, составляем семантическое ядро, пишем уникальный и полезный для пользователей текст. Анализируем навигацию, дизайн. На сайте не должно быть технических ошибок, мешающих продвижению. Исследуем конкурентов. Список работ можно продолжать бесконечно. У нас в блоге есть очень полезная статья от Ирины «Как получить трафик на сайт из поисковых систем».

Если после всех работ трафик так и не появился, возможно, проблема скрыта глубже и потребуется более детальное рассмотрение. Рекомендуем заказать аудит – будем разбираться.

Пояснение терминов «индексация сайта» и «поисковый индекс»

Под индексацией веб-ресурса подразумевают посещение ботами его интернет-страниц, анализ содержащегося в них контента и его добавление в базу данных. Это делается для того, чтобы потом пользователи могли находить информацию на ресурсе по ключевым запросам в поисковых системах.

Проще говоря, юзер заходит в поисковик, вводит в строке поиска нужный ему запрос и в ответ получает список из множества веб-страниц, проиндексированных поисковыми роботами.

Индексация является обязательной процедурой в работе поисковых систем. Для этого создается специальная специализированная база данных, посредством которой и формируются результаты выдачи.

Поисковый индекс любого сайта зависит непосредственно от его контента, внешних и внутренних ссылок, наличия изображений, графиков и прочих материалов. Вводя в поисковой строке запрос, интернет-пользователь обращается к индексу. Затем из него на основании данных осуществляется ранжирование результатов поиска, список страниц, которые выстраиваются по мере уменьшения релевантности запросу.

Представьте, что Всемирная Сеть – это большая библиотека. В ней обязательно должен быть специальный каталог, который делает поиск необходимых материалов гораздо проще. Всем книгам, которые находятся в библиотеке, принадлежит свой шифр. Все шифры объединены темами, разделами и прочими параметрами.

Когда человек приходит в библиотеку и просит книгу на определенную тематику (делает запрос), библиотекарь идет к нужному разделу, достает все книги, соответствующие ему, и подбирает для читателя самую подходящую.

По аналогичному принципу работают и поисковики: пользователь делает запрос, поисковая машина достает все соответствующие страницы и выдает наиболее релевантные.

На заметку. Под занавес прошлого века индексация проходила именно по принципу каталогизации – боты отыскивали на ресурсах ключевые слова, из которых и состояла база данных. В наши дни роботы, помимо ключевиков, учитывают множество других параметров контента, в числе которых уникальность, информативность, грамотность и многое другое. Именно на этом и основывается современная индексация.

С каждым годом поисковые алгоритмы становятся все совершеннее, база данных все больше наполняется дополнительной информацией, при этом поиск для пользователей становится куда легче и более релевантнее.

Скорость индексации

- Некоторые веб-мастера считают, что на скорость индексации влияет количество внешних ссылок: чем их больше у вашего ресурса, тем быстрее происходит индексация.

- Внутренняя ссылка на новую страницу ускорит её индексацию.

- Я знаю по практике, если ваш сайт обновляется постоянно, то боты посещают ваш сайт чаще и скорость индексации страницы возрастает многократно.

- Использование специальных сервисов веб мастеров: Яндекс.Вебмастер, Google Webmaster Tools, Webmaster.mail, Bing Webmaster Tools имеет инструменты для сообщения о новых страницах сайта, что также ускоряет индексацию.